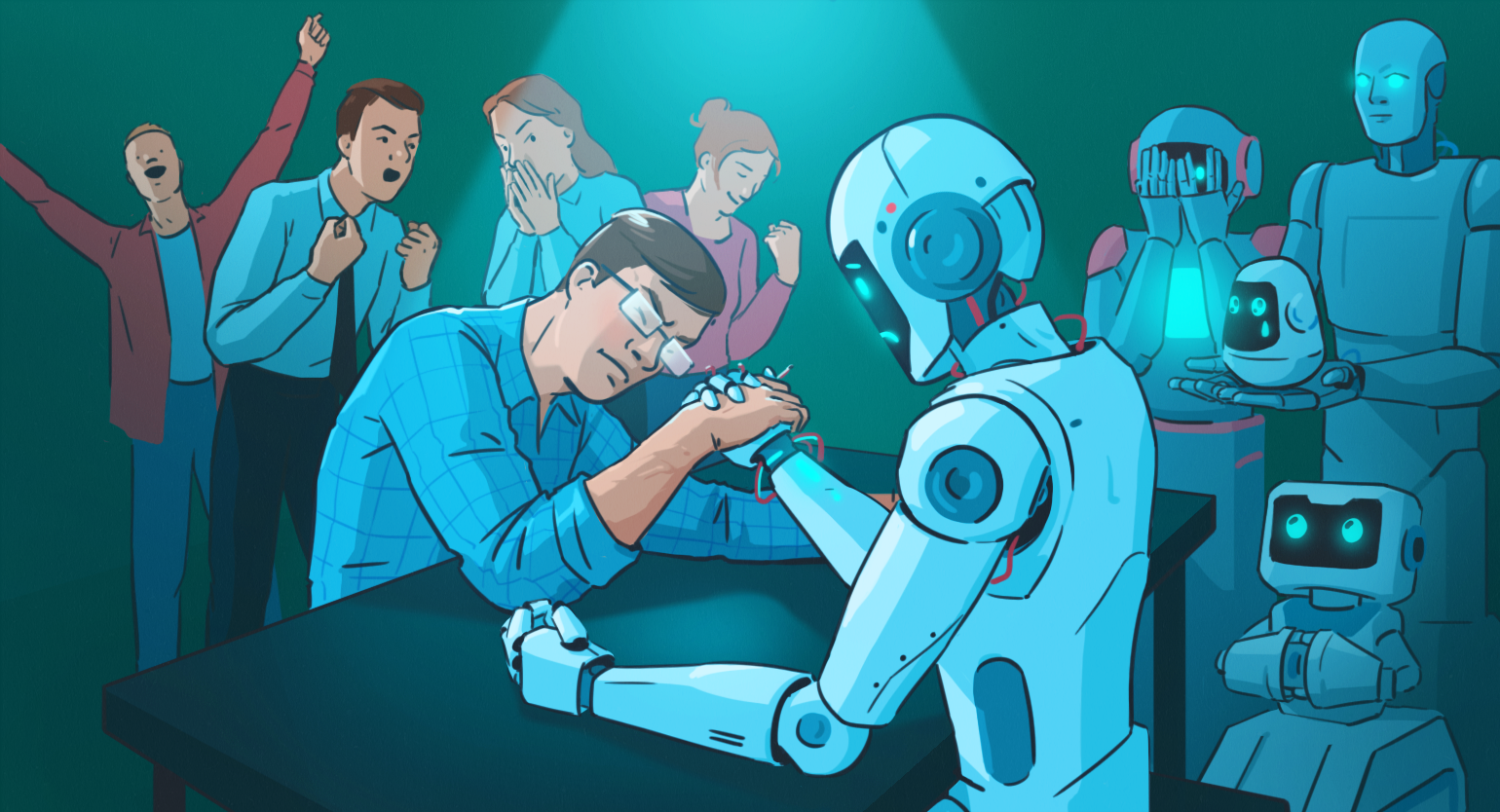

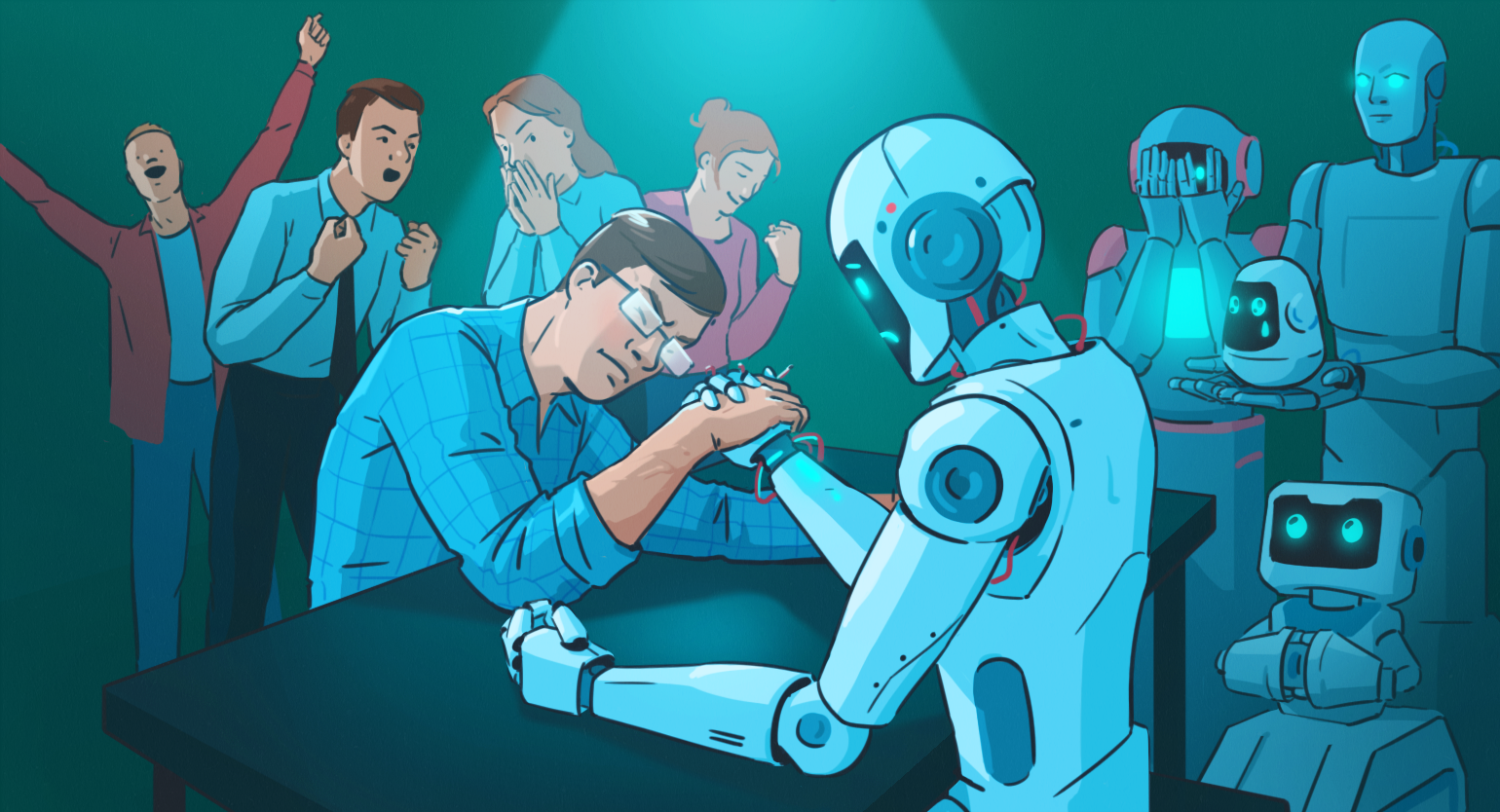

Почему нейросети не заменят L&D-специалистов (по крайней мере пока)

От того, что могут люди, нейросети пока очень далеки, утверждают зарубежные эксперты.

С момента появления ChatGPT и схожих с ним инструментов на основе генеративных нейросетей подзабытая, было, страшилка «нас всех заменят роботы» снова стала актуальной. Уже сейчас искусственному интеллекту прочат роль тьютора и тренера. Но может ли он заменить специалистов по корпоративному обучению?

Своим мнением по этому вопросу поделились главный евангелист компании Obrizum Маркус Бернхардт и доктор философии, исполнительный директор в компании Quinnovation Кларк Куинн в своей статье для Learning Guild.

Почему важно знать, как работают чат‑боты на основе нейросетей

Эксперты уверены: опыт и возможности специалистов-людей роботы «заместить» пока не могут. Причина у этого одна — то, как устроены новые технологии. Чат‑боты, которые наделали шуму в образовательной практике, представляют собой большие языковые модели. Их обучают на значительных объёмах текста, но и хороши они настолько же, насколько хорош материал для обучения. Чем лучше нейросеть подготовлена по конкретной теме, тем лучше она будет отвечать на вопросы человека.

Однако логики, истинного знания или представления об описываемом мире у этой технологии нет. Она просто «понимает», как устроен тот или иной язык и как строится структура текста. На основе этого понимания чат-бот «предполагает», как должен выглядеть текст, и выдаёт оптимальную «догадку».

«Как ребёнок, который услышал обсуждаемое родителями и запомнил это, ИИ-инструмент может „пересказать“ идеи и концепции. Хотя его ответы могут создать видимость „понимания“, мы на самом деле знаем, что ребёнок (или ИИ) не понял, что именно говорилось, хотя ответ может показаться забавным — или постыдным — для всех взрослых», — объясняют авторы статьи.

«Умный» чат-бот может начать придумывать ответ — предлагать ссылки на несуществующие исследования и статьи, — когда ИИ предполагает, что они должны быть дальше в тексте, но не находит подходящих.

Кларк Куинн и Маркус Бернхардт приводят такой пример: ChatGPT неплохо справился с экзаменами для вступления в адвокатуру — потому что этот экзамен основан на использовании языка права, судебных дел и прецедентов. Накопленный огромный массив таких текстов позволяет нейросети хорошо уловить их структуру, суть и особенности, поэтому она довольно точно «угадывает» ответы.

А вот на экзаменах и олимпиадах по таким предметам, как физика, химия или математика, языковые модели уже не так хороши. Причина проста: там нужно не просто пересказывать или формулировать некие концепции, а искать ответ на их основе, логически мыслить и рассуждать. Проще говоря, думать — а по‑настоящему чат-боты на это неспособны.

Читайте также:

Почему чат-боты пока что не станут полноценными помощниками L&D

Устройство больших языковых моделей приводит к ограничениям в их использовании. В сфере корпоративного обучения авторы статьи выделяют четыре таких препятствия:

- Неспособность работать с изображениями.

Конечно, для генерации изображений есть свои платформы на основе генеративных нейросетей — та же Midjourney. Однако работают они сами по себе, без связи с текстовыми нейросетями. Если вам потребуется оформить инфографику или сделать картинку для наглядности, текстовый чат-бот не справится с этим самостоятельно. Это Кларк Куинн и Маркус Бернхардт считают серьёзным ограничением: визуальная составляющая в обучении важна не меньше, чем текстовая.

- Переписывание текста.

Чат-боты в основном пересказывают другие тексты для своих ответов, а не цитируют оригиналы. И хотя в некоторых случаях ответ будет правдивым, в обучении полагаться на авось, конечно, не следует: авторы статьи считают, что это может привести к катастрофе — особенно если речь идёт о таких темах, как безопасность, здоровье или комплаенс.

- «Галлюцинации».

Если нейросеть не очень хорошо «знакома» с конкретной темой или сферой (проще говоря, ей не хватает данных), то она начинает «галлюцинировать» — придумывать фантастические по содержанию ответы на запрос, хотя по формулировкам они «лингвистически верные», отмечают эксперты. То есть она попросту выдумывает факты или ссылки на источники.

- Невозможность действительно учить.

Для обучения нужно, чтобы преподаватель или тренер не только владел знаниями и готов был ими поделиться, но и умел их передать правильным образом. А с ответами больших языковых моделей на запросы есть такая проблема: вы не узнаете о том, о чём вы не спросили. То есть может получиться как в том анекдоте, когда кто-то кого-то чему-то учит, человек думает, что во всём разобрался, но когда начинает применять на практике, ничего не получается — и выясняется, что ему не объяснили самую важную деталь. И когда он спрашивает учителя: «Почему ты никогда не говорил мне об этом?» — получает ответ: «Так ты и не спрашивал».

Проще говоря, нейросеть — не человек и тем более не профессионал в обучении, она не может предусмотреть всё, о чём нужно предупредить новичка, не знакомого с темой.

Словом, эксперты приходят к выводу, что обучение без человека невозможно. Но понимание принципов работы генеративных нейросетей и их ограничений поможет создавать действительно качественные учебные продукты, грамотно подходить к выбору инструментов и не полагаться на технологии слепо.