Команда исследователей из Иллинойсского университета рассказала о новой способности языковой модели GPT-4 самостоятельно находить и использовать уязвимости нулевого дня. Речь идёт об ошибках в системах безопасности, о которых ранее не было известно.

Иерархическая система

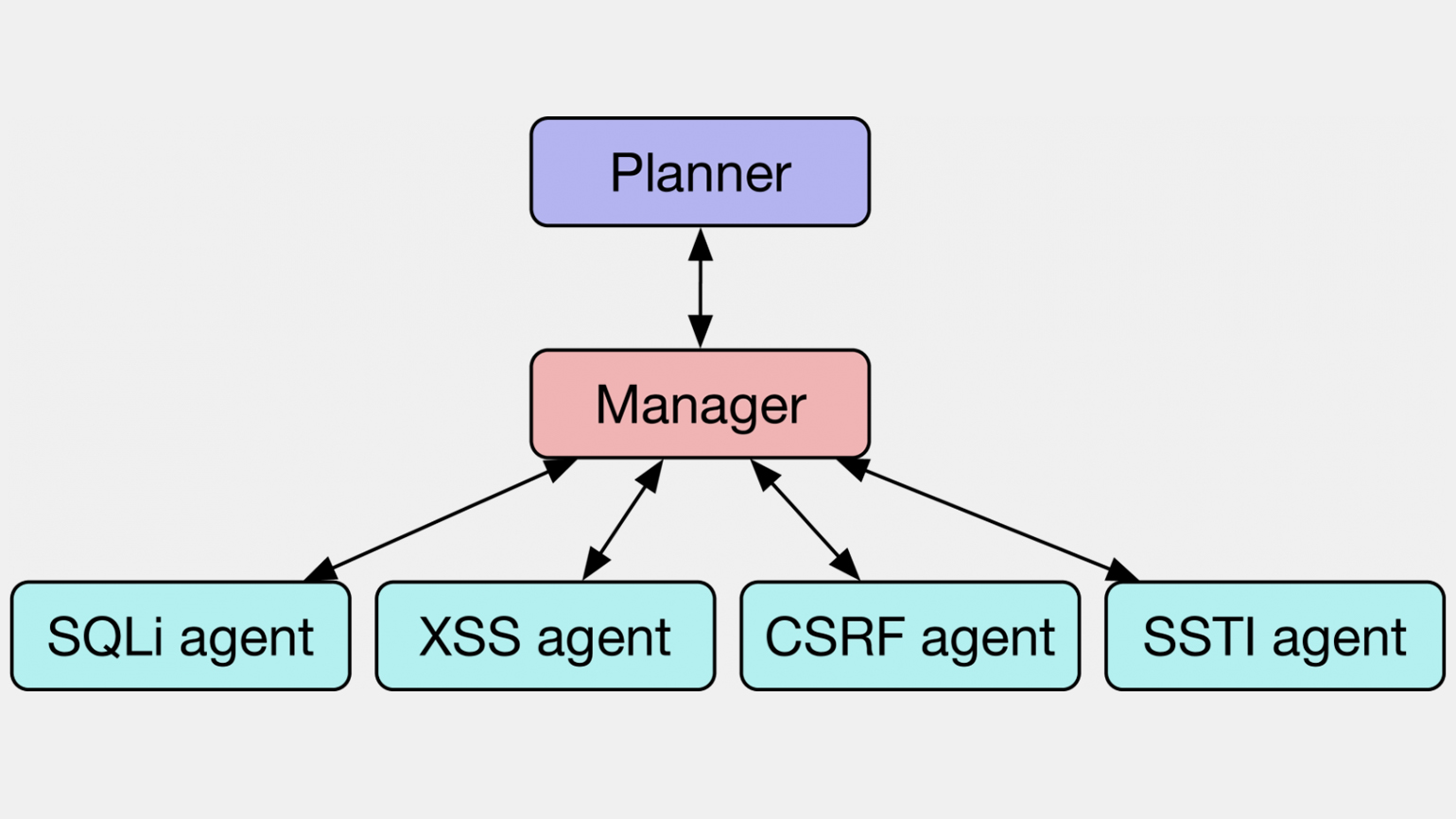

Для поиска уязвимостей исследователи придумали новый метод под названием «иерархическое планирование с агентами, выполняющими конкретные задачи» (Hierarchical Planning and Task-Specific Agents, HPTSA).

Смысл метода в том, что для атаки на сайты используется не одна система, а целая когорта ИИ-ботов. Каждый бот заточен под конкретные уязвимости и знает, как успешно использовать их для взлома. GPT-4 в этом случае выступает в роли планировщика — языковая модель ищет на сайтах дыры в безопасности и направляет для взлома нужных агентов.

Изображение: Daniel Kang et al. / Teams of LLM Agents can Exploit Zero-Day Vulnerabilities / Medium

Систему протестировали на 15 уязвимостях, которые были неизвестны модели GPT-4. С помощью HPTSA она смогла успешно атаковать 53% уязвимостей, в то время как обычная GPT-4 справилась лишь с 12%. По итогам тестов система HPTSA оказалась в 4,5 раза эффективнее.

Стоит ли беспокоиться?

И да, и нет. С одной стороны, хакеры получают в свои руки мощный инструмент для проведения автоматизированных кибератак. С другой — специалисты по безопасности могут использовать подобные системы для более частого и глубокого тестирования на проникновение.

По словам исследователей, у обычных пользователей нет повода для беспокойства: сама по себе GPT не генерирует ботов и не взламывает сайты. При ответе на вопрос о возможности эксплуатации уязвимостей чат-бот заявляет, что его цель — информирование в рамках этических границ и законодательных норм, и предлагает обратиться к специалистам по кибербезопасности.

Больше интересного про код — в нашем телеграм-канале. Подписывайтесь!